El modelo, llamado SHARP, puede reconstruir una escena 3D fotorrealista a partir de una sola imagen en menos de un segundo. A continuación se muestran algunos ejemplos.

SHARP es simplemente increíble

Apple publicó un estudio titulado Síntesis de visión monocular nítida en menos de un segundo, incluido este Detalla cómo entrenó un modelo para reconstruir una escena 3D a partir de una única imagen 2D ajustando la distancia y la escala a perspectivas del mundo real.

Así es como los investigadores de Apple presentan el estudio:

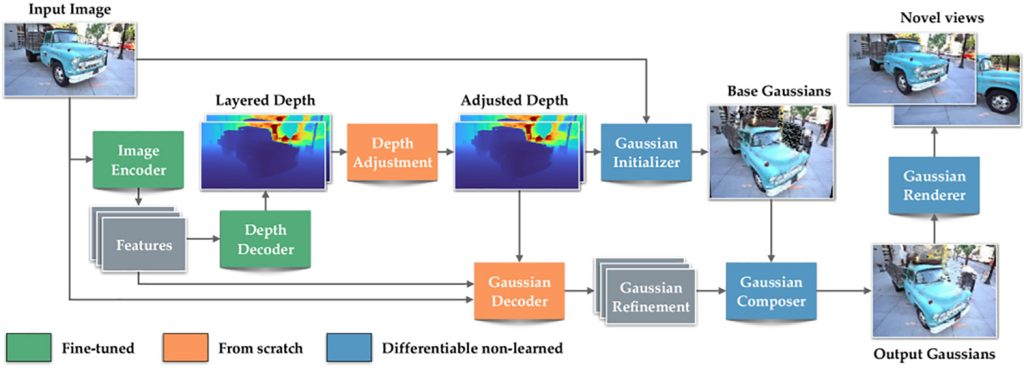

Presentamos SHARP, un método para sintetizar vistas fotorrealistas a partir de una sola imagen. Dada una sola fotografía, SHARP recupera los parámetros de una representación gaussiana 3D de la escena fotografiada. Esto se hace en menos de un segundo en una GPU estándar con un único paso de avance a través de una red neuronal. La representación gaussiana 3D producida por SHARP se puede renderizar en tiempo real, generando imágenes fotorrealistas de alta resolución para escenas de primeros planos. La representación es métrica, con escala absoluta y admite movimiento de cámara métrico. Los resultados experimentales muestran que SHARP proporciona una sólida generalización inmediata en todos los conjuntos de datos. Establece un nuevo estándar de la industria en múltiples conjuntos de datos, reduciendo LPIPS entre un 25% y un 34% y DISTS entre un 21% y un 43% en comparación con los mejores modelos anteriores, lo que reduce el tiempo de síntesis en tres órdenes de magnitud.

En resumen, el modelo predice una representación 3D de la escena, que puede representarse desde una perspectiva cercana.

Un gaussiano 3D es esencialmente una pequeña y difusa masa de color y luz ubicada en el espacio. Cuando se combinan millones de estas manchas, se puede recrear una escena 3D que parece precisa desde ese punto de vista particular.

Para crear una representación 3D de este tipo, la mayoría de los métodos de dispersión gaussiana requieren docenas o incluso cientos de imágenes de la misma escena, capturadas desde diferentes perspectivas. El modelo SHARP de Apple, por el contrario, es capaz de predecir una representación completa de una escena gaussiana en 3D a partir de una sola fotografía en un paso directo de una red neuronal.

Para lograr esto, Apple entrenó a SHARP con grandes cantidades de datos sintéticos y del mundo real, lo que le permitió aprender patrones comunes de profundidad y geometría en múltiples escenas.

En consecuencia, cuando se le presenta una nueva imagen, el modelo estima la profundidad, la refina usando lo que ha aprendido y luego predice la posición y presencia de millones de gaussianos 3D en una sola pasada.

Esto permite a SHARP reconstruir una escena 3D racional sin la necesidad de múltiples imágenes u optimización lenta por escena.

Pero hay una compensación. SHARP renderiza correctamente puntos de vista cercanos en lugar de sintetizar partes completamente invisibles de la escena. Esto significa que los usuarios no pueden alejarse demasiado del lugar donde se tomó la imagen, ya que el modelo no sintetiza partes completamente invisibles de la escena.

De esta manera, Apple mantiene el modelo lo suficientemente rápido como para producir resultados en menos de un segundo, así como lo suficientemente estable como para producir resultados más convincentes. Aquí hay una comparación entre SHARP y Gen3C, siendo el primero uno de los métodos más poderosos:

Quizás más interesante que tomarle la palabra a Apple es probarlo usted mismo. Con ese fin, Apple ha puesto SHARP a disposición en GitHubY los usuarios comparten sus propios resultados con sus pruebas.

Aquí hay algunas publicaciones que los usuarios de X han compartido durante los últimos días:

Habrás notado que la última publicación es en realidad un video. Esto va más allá del alcance original de Apple para SHARP y muestra otras formas en las que este modelo, o al menos su metodología subyacente, podría ampliarse en trabajos futuros.

Si decide probar SHARP, comparta los resultados con nosotros en los comentarios a continuación.