Basado en un modelo anterior llamado Unigen, un equipo de investigadores de Apple está demostrando Unigen 1.5, un sistema que puede manejar la comprensión, generación y edición de imágenes dentro de un solo modelo. Aquí están los detalles.

Construyendo sobre el UniGen original

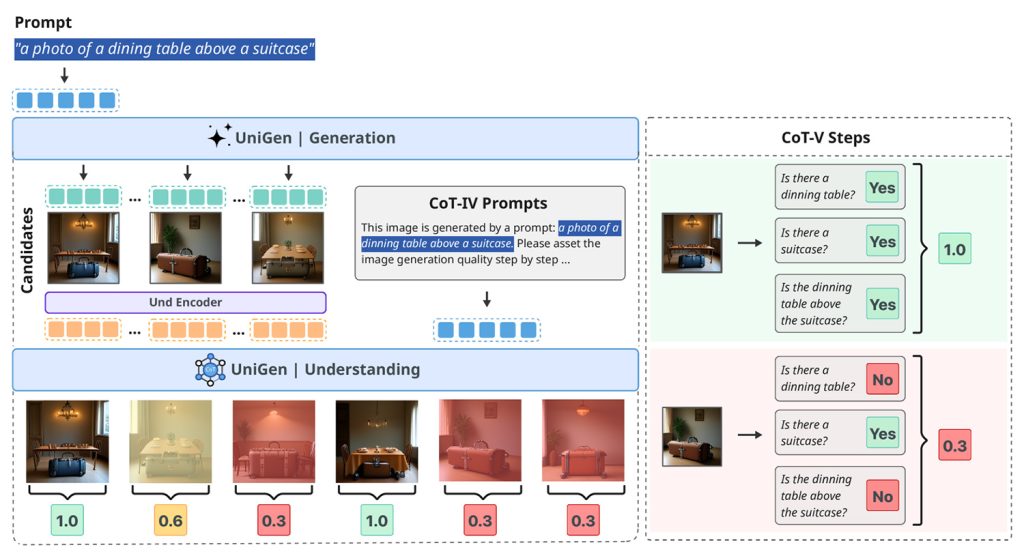

En mayo pasado, un equipo de investigadores de Apple publicó un estudio llamado UniGen: técnicas avanzadas de capacitación y prueba para la comprensión y generación multimodal unificada.

En ese trabajo, introdujeron un modelo de lenguaje grande multimodal unificado capaz de comprender y generar imágenes dentro de un solo sistema sin depender de modelos separados para cada tarea.

Ahora, Apple ha publicado una continuación de esta investigación, en un artículo titulado UniGen-1.5: Mejora de la generación y edición de imágenes mediante la unificación de recompensas en el aprendizaje por refuerzo.

UniGen-1.5, explicado

Esta nueva investigación amplía UniGen al agregar capacidades de edición de imágenes al modelo, pero dentro de un marco unificado, en lugar de comprensión, generación y edición fragmentadas en diferentes sistemas.

Integrar estas capacidades en un solo sistema es un desafío porque se requieren diferentes métodos para comprender y generar imágenes. Sin embargo, los investigadores sostienen que un modelo unificado puede aprovechar su comprensión para mejorar el rendimiento de la generación.

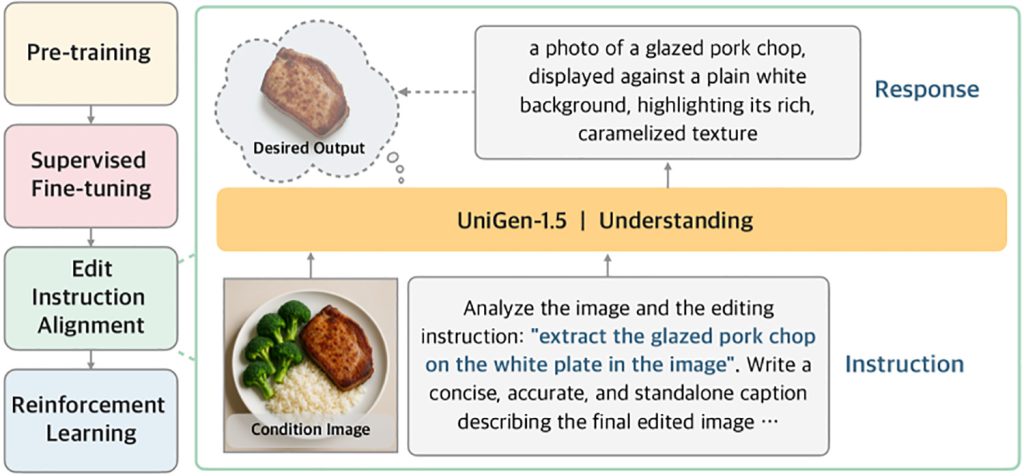

Según ellos, uno de los principales desafíos de la edición de imágenes es que los modelos a menudo tienen dificultades para comprender completamente instrucciones de edición complejas, especialmente cuando los cambios son sutiles o muy específicos.

Para solucionar esto, UniGen-1.5 introduce un nuevo paso posterior al entrenamiento llamado editar alineación de instrucciones:

“Además, observamos que el modelo sigue siendo inadecuado para manejar varios escenarios de edición después de un ajuste fino supervisado debido a una comprensión insuficiente de las instrucciones de edición. Por lo tanto, proponemos la alineación de las instrucciones de edición como una etapa post-SFT leve para mejorar la alineación entre las instrucciones de edición y la semántica, si captura la imagen de destino y la imagen de mota. Optimizado para predecir el contenido semántico de la imagen de destino a través de la descripción del texto se optimiza experimentalmente. Los resultados indican que esta fase es muy beneficiosa para aumentar el rendimiento de edición

En otras palabras, antes de pedirle al modelo que mejore su resultado mediante el aprendizaje por refuerzo (que recompensa al modelo por un buen resultado y castiga el malo), los investigadores primero lo entrenan para adivinar una descripción textual detallada de lo que debe contener la imagen editada basándose en la imagen original y las instrucciones de edición.

Este paso intermedio ayuda al modelo a internalizar mejor la edición prevista antes de crear la imagen final.

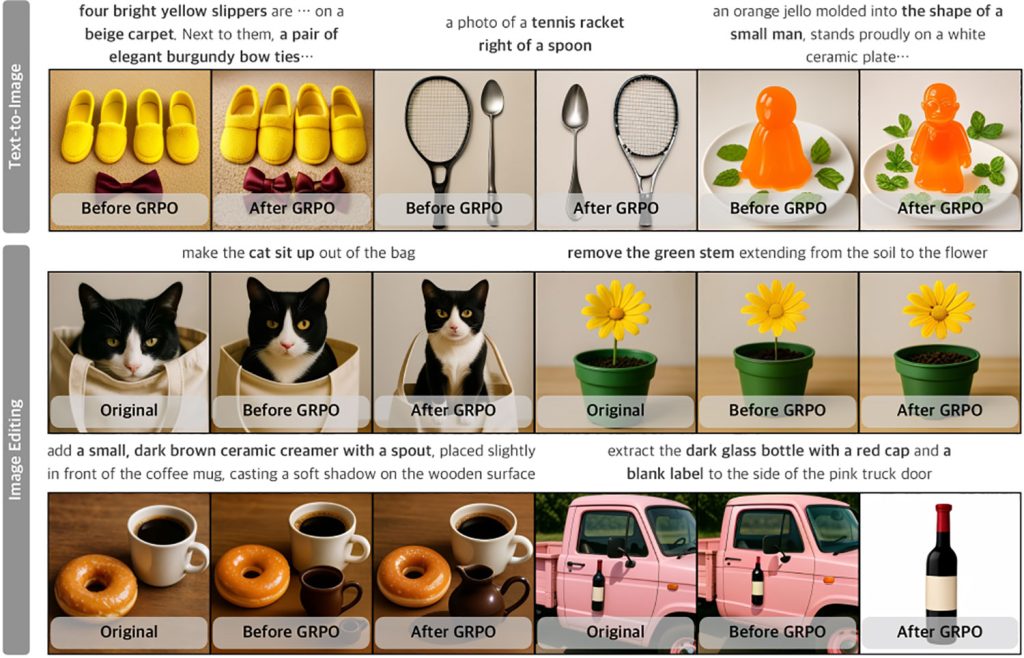

Luego, los investigadores emplearon el aprendizaje por refuerzo en lo que podría decirse que es la contribución más importante del artículo: utilizaron el mismo sistema de recompensa tanto para la creación como para la edición de imágenes, lo que anteriormente era un desafío porque las ediciones pueden variar desde cambios menores hasta transformaciones completas.

Como resultado, cuando se prueba en varios puntos de referencia estándar de la industria que miden qué tan bien los modelos siguen instrucciones, mantienen la calidad visual y manejan ediciones complejas, UniGen-1.5 iguala o supera a varios modelos de lenguaje grande multimodales abiertos y propietarios de última generación:

A través de los esfuerzos anteriores, UniGen-1.5 proporciona una base sólida para avanzar en la investigación sobre MLLM unificado y establece un rendimiento competitivo en todos los criterios de comprensión, generación y edición de imágenes. Los resultados experimentales muestran que UniGen-1.5 obtuvo una puntuación de 0,89 y 86,83 en GenEval y DPG-Bench, superando significativamente a métodos recientes como BAGEL y BLIP3o. Para la edición de imágenes, UniGen-1.5 logró una puntuación general de 4,31 en ImgEdit, superando a los modelos recientes de código abierto como OminiGen2 y comparable a modelos propietarios como GPT-Image-1.

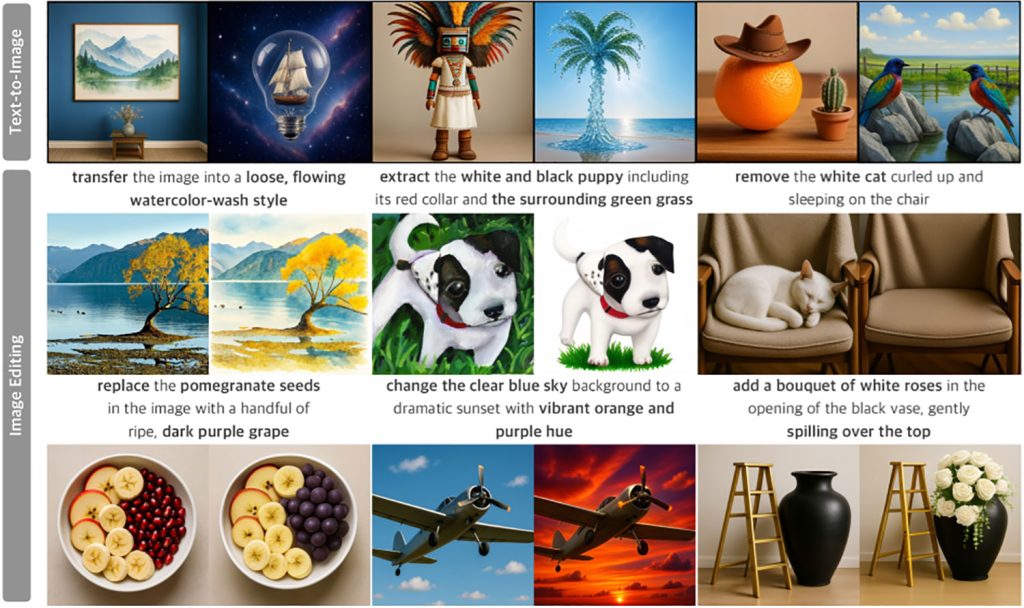

A continuación se muestran algunos ejemplos de las capacidades de generación de texto a imagen y edición de imágenes de UniGen-1.5 (desafortunadamente, los investigadores parecen haber cortado por error las indicaciones para la parte de texto a imagen en la primera imagen):

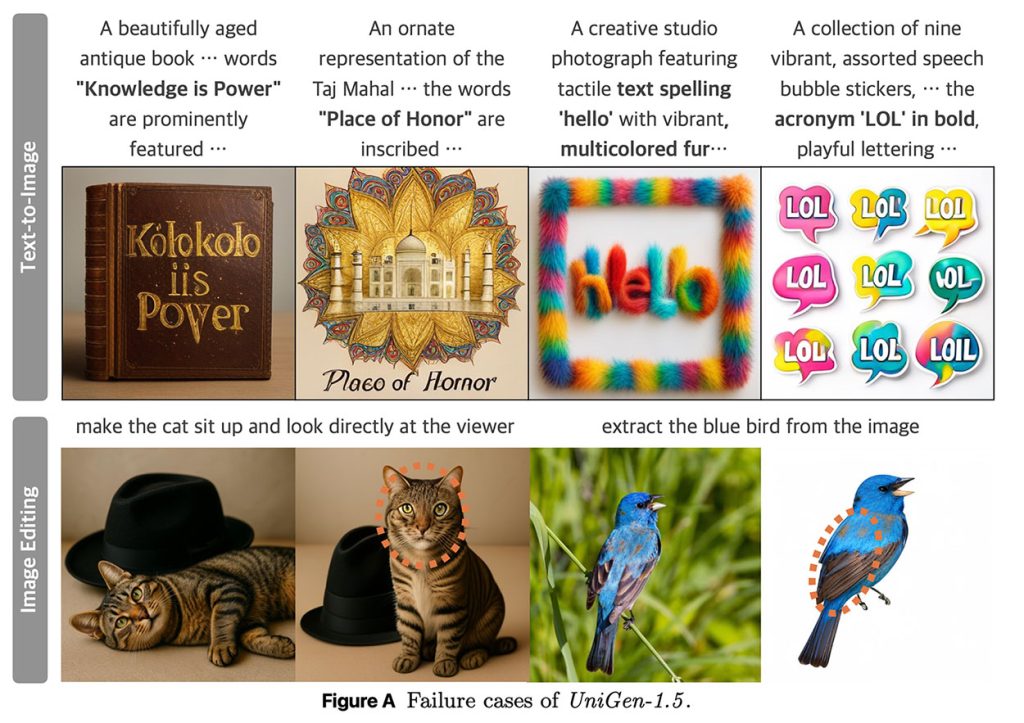

Los investigadores señalan que UniGen-1.5 tiene problemas con la generación de texto y con la coherencia de la identidad en determinadas situaciones:

Los eventos de falla de UniGen-1.5 tanto en la generación de texto a imagen como en las tareas de edición de imágenes se ilustran en la Figura A. En la primera fila, presentamos ejemplos en los que UniGen-1.5 no logra representar los caracteres de texto correctamente, mientras el detokenizador discreto y liviano lucha por controlar los detalles necesarios para producir texto detallado. En la segunda fila, mostramos dos ejemplos con cambios de identidad visibles resaltados por círculos, es decir, cambios en la textura y forma del pelaje facial de los gatos y diferencias en el color de las plumas de las aves. UniGen-1.5 requiere más mejoras para abordar estas limitaciones.

Puedes encontrar el estudio completo aquí. aquí.