Apple continúa explorando cómo la IA generativa puede mejorar los procesos de desarrollo de aplicaciones. Esto es lo que están mirando.

Un poco de trasfondo

Hace unos meses, un equipo de investigadores de Apple publicó un interesante estudio sobre el entrenamiento de IA para generar código de interfaz de usuario funcional.

En lugar de la calidad del diseño, el estudio se centró en garantizar que el código generado por IA realmente compilara y coincidiera aproximadamente con las indicaciones del usuario en términos de cómo debería funcionar y verse la interfaz.

El resultado fue UICoder, una familia de modelos de código abierto sobre los que puedes leer más aquí.

Nueva investigación

Ahora, parte del equipo responsable de UICoder ha publicado un nuevo artículo titulado “Mejora de los modelos de generación de interfaces de usuario a partir de los comentarios de los diseñadores“

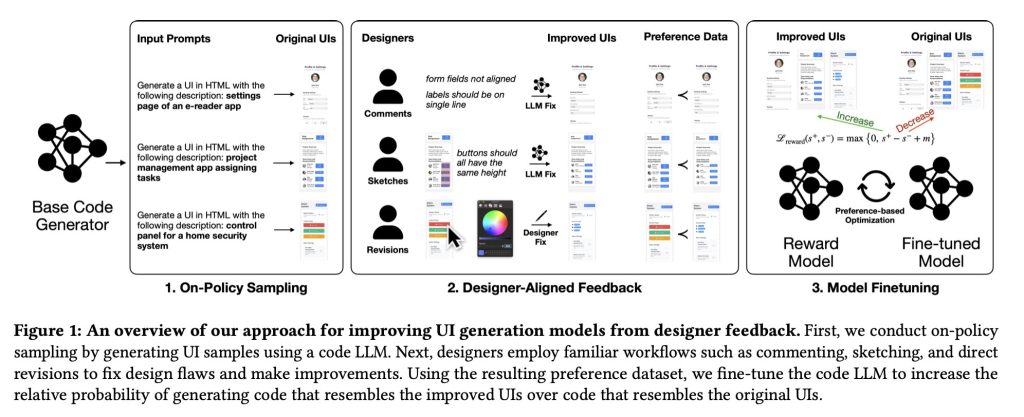

En él, los investigadores explican que los métodos existentes de aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) no son los mejores métodos para capacitar a los LLM para crear de manera confiable UI bien diseñadas, porque “no se alinean bien con los flujos de trabajo de los diseñadores e ignoran la rica lógica utilizada para criticar y mejorar los diseños de UI”.

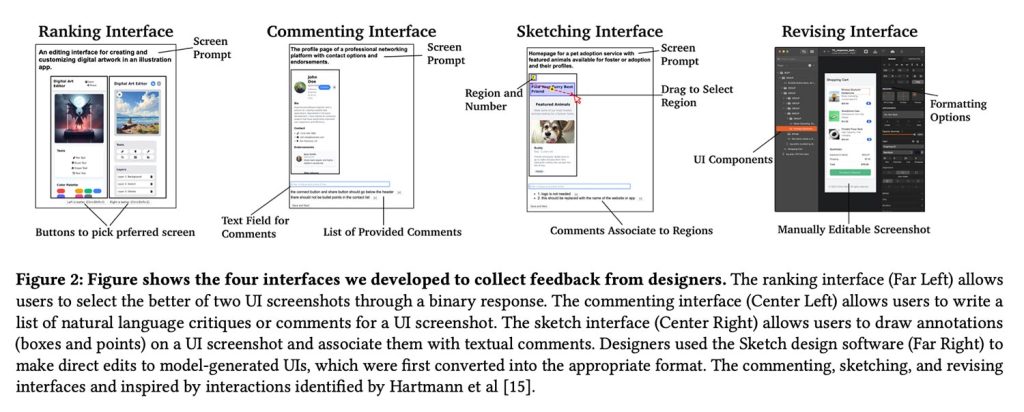

Para afrontar este problema, proponen una ruta diferente. Sus diseñadores profesionales utilizaron comentarios, bocetos e incluso ediciones prácticas para criticar y mejorar directamente la interfaz de usuario generada por el modelo, y luego transformar los cambios del antes y el después en datos utilizados para ajustar el modelo.

Esto les permite entrenar un modelo de recompensa sobre mejoras de diseño concretas, enseñando efectivamente al generador de interfaz de usuario a elegir diseños y elementos que reflejen mejor los criterios de diseño del mundo real.

configuración

En total, participaron en el estudio 21 diseñadores:

Los participantes reclutados tienen distintos niveles de experiencia en diseño profesional que van desde 2 hasta más de 30 años. Los participantes también trabajaron en diferentes áreas del diseño, como diseño UI/UX, diseño de producto y diseño de servicios. Los diseñadores participantes también mencionaron la frecuencia con la que se realizan revisiones de diseño (tanto formales como informales) en las actividades laborales: desde una vez cada pocos meses hasta varias veces por semana.

Los investigadores recopilaron 1.460 anotaciones, que luego se convirtieron en ejemplos “preferidos” de UI emparejados, contrastando la interfaz original generada por el modelo con las versiones mejoradas de los diseñadores.

Esto, a su vez, se utilizó para entrenar un modelo de recompensa para ajustar el generador de UI:

El modelo de recompensa acepta i) una imagen renderizada (una captura de pantalla de la UI) y ii) una descripción en lenguaje natural (una descripción objetivo de la UI). Estas dos entradas se introducen en el modelo para generar una puntuación numérica (premio), que se calibra para que un diseño visual de buena calidad dé como resultado puntuaciones más altas. Para asignar recompensas al código HTML, utilizamos el proceso de representación automatizada descrito en la Sección 4.1 para representar el código en las capturas de pantalla utilizando el software de automatización del navegador.

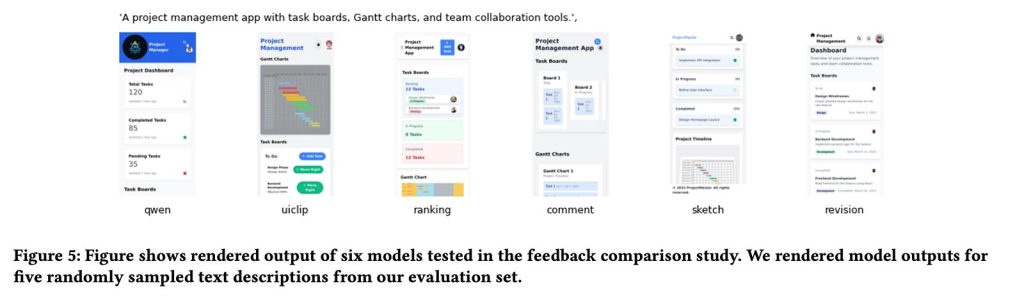

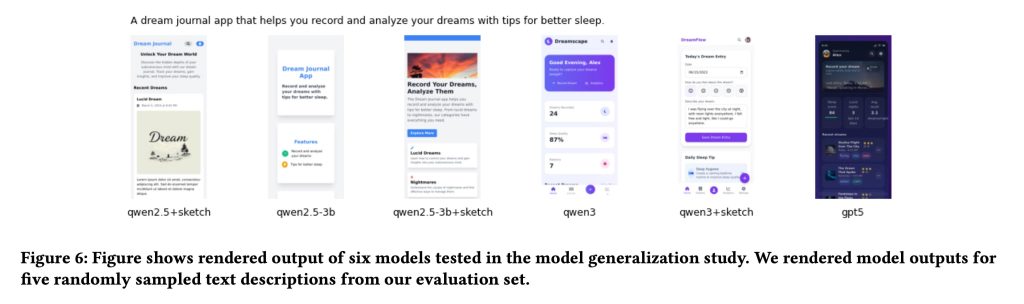

Para el modelo generador, Apple utilizó Qwen2.5-Coder como modelo base inicial para la generación de UI y luego aplicó el mismo modelo de recompensa entrenado por diseñadores a variantes de Qwen más pequeñas y nuevas para probar qué tan bien se generalizaba el método en diferentes tamaños y versiones de modelos.

Curiosamente, como señalan los propios autores del estudio, esa estructura se parece mucho a un oleoducto RLHF tradicional. La diferencia, argumentan, es que la señal de aprendizaje proviene de flujos de trabajo nativos del diseñador (comentarios, bocetos y revisiones prácticas) en lugar de aprobación o desaprobación o simples datos de clasificación.

resultado

Entonces, ¿realmente funciona? Según los investigadores, la respuesta es sí, con importantes salvedades.

En general, los modelos entrenados con comentarios nativos del diseñador (especialmente con bocetos y correcciones directas) producen diseños de interfaz de usuario de calidad significativamente mayor que los modelos base y las versiones entrenadas utilizando solo clasificación o datos de calificación convencionales.

De hecho, los investigadores notaron que su modelo de mejor rendimiento (codificador Qwen3 ajustado con retroalimentación de boceto) superó a GPT-5. Quizás lo más impresionante es que, en última instancia, se derivó de sólo 181 anotaciones de bocetos de los diseñadores.

Nuestros resultados muestran que el ajuste fino de nuestro modelo de recompensa basado en bocetos conduce consistentemente a mejoras en la capacidad de generación de UI para todas las líneas de base probadas, lo que sugiere generalización. También mostramos que una pequeña cantidad de comentarios de expertos de alta calidad permite que los modelos pequeños superen a los LLM propietarios más grandes en la generación de UI.

En cuanto a la precaución, los investigadores señalan que el contenido juega un papel importante cuando se trata de qué constituye exactamente una buena interfaz:

Un desafío importante en nuestro trabajo y otros problemas centrados en el ser humano es la gestión de la subjetividad y las múltiples resoluciones de los problemas de diseño. Ambos fenómenos pueden conducir a una alta heterogeneidad de respuestas, lo que plantea desafíos para los procesos de clasificación de respuestas ampliamente utilizados.

En la investigación, esta variación se manifestó como un desacuerdo sobre qué diseños eran realmente mejores. Cuando los investigadores evaluaron de forma independiente los mismos pares de UI que los diseñadores habían clasificado, estuvieron de acuerdo con la elección de los diseñadores el 49,2% de las veces, apenas al aire.

Por otro lado, cuando los diseñadores proporcionaron comentarios dibujando mejoras o editando directamente las UI, el equipo de investigación estuvo mucho más de acuerdo con esas mejoras: 63,6% para los bocetos y 76,1% para la edición directa.

En otras palabras, cuando los diseñadores podían mostrar específicamente lo que querían cambiar en lugar de elegir entre dos opciones, era más fácil ponerse de acuerdo sobre lo que realmente significaba “bueno”.

Para una mirada en profundidad al estudio con más aspectos técnicos, material de capacitación y más ejemplos de interfaces, Sigue este enlace.