Un equipo de investigadores de Apple se propuso comprender qué esperan los usuarios reales de los agentes de IA y cómo deberían interactuar con ellos. Esto es lo que encontraron.

Apple explora las tendencias de UX para la era de los agentes de IA

En investigación, título Mapeo del espacio de diseño de experiencia de usuario para agentes de uso informático.Un equipo de cuatro investigadores de Apple dice que si bien el mercado está invirtiendo mucho en desarrollar y evaluar agentes de IA, se han pasado por alto algunos aspectos de la experiencia del usuario: cómo los usuarios quieren interactuar con ellos y cómo deberían verse estas interfaces.

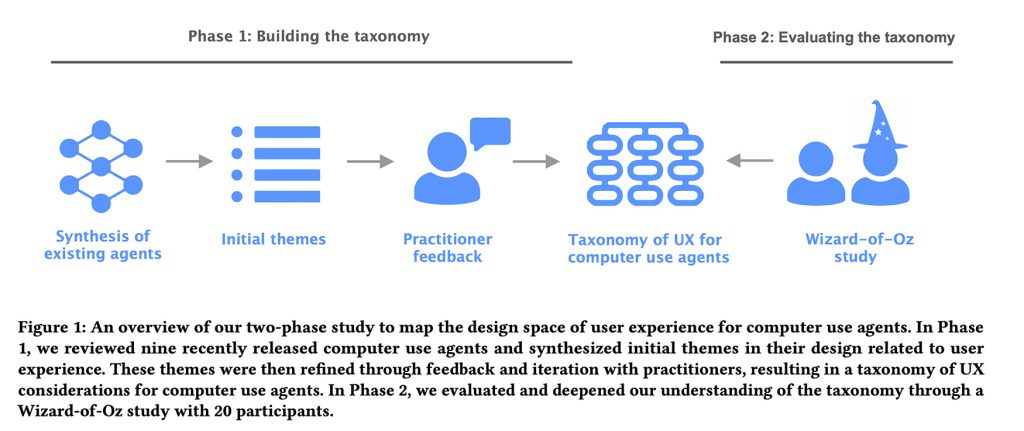

Para explorar esto, dividieron el estudio en dos fases: primero, identificaron patrones de UX clave y consideraciones de diseño que los laboratorios de IA están incorporando a los agentes de IA existentes. Luego, probaron y refinaron esas ideas mediante estudios prácticos de usuarios, un método interesante llamado El Mago de Oz.

Al observar cómo esos patrones de diseño se mantienen en las interacciones de los usuarios del mundo real, pudieron identificar qué diseños actuales de agentes de IA se alinean con las expectativas de los usuarios y cuáles se quedan cortos.

Etapa 1: Taxonomía

Los investigadores analizaron nueve agentes de escritorio, móviles y basados en la web, entre ellos;

- Herramientas de computación en la nube

- adepto

- Operador OpenAI

- ailis

- UI mágica

- UI-TARS

- Proyecto Marinero

- IA de taxi

- AutoGLM

Luego, consultaron con “8 profesionales que son diseñadores, ingenieros o investigadores que trabajan en el dominio de UX o AI en una gran empresa de tecnología”, lo que les ayudó a crear una taxonomía integral con cuatro categorías, 21 subcategorías y 55 características de ejemplo que cubren consideraciones clave de UX detrás de los agentes de AI que utilizan computadoras.

Incluye cuatro categorías principales:

- Preguntas de usuario: Cómo los usuarios ingresan comandos

- Explicabilidad de las actividades de los agentes.: Qué información presentar al usuario sobre la acción del agente

- control de usuario: Cómo pueden intervenir los usuarios

- Modelos mentales y expectativas.: Cómo ayudar a los usuarios a comprender las capacidades de los agentes

En resumen, ese marco permite a los agentes presentar sus planes a los usuarios, comenzando con la interfaz, cómo realizan sus capacidades, detectar errores y permitir a los usuarios tomar medidas cuando algo sale mal.

Con todo esto en la mano, pasaron a la Fase 2.

Fase 2: estudio del Mago de Oz

Los investigadores reclutaron a 20 usuarios con experiencia previa con agentes de IA y les pidieron que interactuaran con un agente de IA a través de una interfaz de chat para realizar una tarea de alquiler vacacional o una tarea de compra en línea.

De la investigación:

A los participantes se les proporcionó una interfaz de chat de usuario simulada a través de la cual podían interactuar con un “agente” interpretado por el investigador. Mientras tanto, al participante también se le presentó la interfaz de ejecución del agente, donde el investigador actuó como agente e interactuó con el UL en la pantalla según los comandos del participante. En la interfaz de chat del usuario, los participantes pueden ingresar preguntas de texto en lenguaje natural, que luego aparecen en el hilo del chat. Luego, el “agente” comienza a ejecutarse, donde el investigador controla el mouse y el teclado de su extremo para simular las acciones del agente en la página web. Cuando el investigador completa la tarea, ingresa una tecla de acceso directo que publica un mensaje de “tarea completa” en el hilo del chat. Durante la ejecución, los participantes pueden usar un botón de interrupción para detener al agente y aparecerá el mensaje “Agente interrumpido” en el chat.

En otras palabras, sin que los usuarios lo supieran, el agente de IA era, de hecho, un investigador sentado en la habitación de al lado, que leía las instrucciones en texto y realizaba la tarea solicitada.

Para cada tarea (alquiler vacacional o compras en línea), se pidió a los participantes que realizaran seis funciones con el agente de IA, algunas de las cuales el agente fallaría intencionalmente (como quedarse atascado en un bucle de navegación) o cometería errores deliberados (como seleccionar algo diferente de las instrucciones del usuario).

Al final de cada sesión, los investigadores pidieron a los participantes que reflexionaran sobre su experiencia y sugirieran características o cambios para mejorar la interacción.

También analizaron grabaciones de video y registros de chat de cada sesión para identificar temas recurrentes de comportamiento del usuario, expectativas y puntos débiles al interactuar con el agente.

Resultados principales

Una vez que todo estuvo dicho y hecho, los investigadores descubrieron que los usuarios querían tener visibilidad de lo que estaban haciendo los agentes de IA, pero no microgestionar cada paso, de lo contrario podrían realizar las tareas ellos mismos.

También concluyeron que los usuarios quieren diferentes comportamientos de los agentes dependiendo de si están explorando opciones o realizando una tarea familiar. De manera similar, las expectativas de los usuarios varían según si están familiarizados con la interfaz. Cuanto menos familiarizados estaban, más buscaban claridad, pasos intermedios, explicaciones y pausas de confirmación (incluso en situaciones de bajo riesgo).

También descubrieron que las personas quieren tener más control cuando las acciones conllevan consecuencias tangibles (como realizar una compra, cambiar la cuenta o los datos de pago, o comunicarse con otras personas en su nombre), y la confianza se rompe rápidamente cuando los agentes hacen suposiciones silenciosas o cometen errores.

Por ejemplo, cuando el agente encontró una opción poco clara en una página, o se desvió del plan original sin marcarlo claramente, los participantes indicaron al sistema que hiciera una pausa y pidiera una aclaración, en lugar de elegir algo aparentemente aleatorio y seguir adelante.

En el mismo sentido, los participantes informaron que se sentían incómodos cuando el agente no era transparente a la hora de tomar una decisión en particular, especialmente cuando esa elección podía llevar a seleccionar el producto equivocado.

Considerándolo todo, este es un estudio interesante para los desarrolladores de aplicaciones que buscan incorporar capacidades de agencia en sus aplicaciones, y puede leerlo completo aquí. aquí.