Los investigadores de Apple han desarrollado un modelo de IA que mejora drásticamente las fotografías extremadamente oscuras al integrar un modelo de imagen basado en difusión directamente en el proceso de procesamiento de imágenes de la cámara, lo que permite recuperar detalles de los datos sin procesar del sensor que normalmente se perderían. Así es como lo hicieron.

Problema con fotografías con poca luz extrema

Probablemente tomaste una foto demasiado oscura, lo que resultó en una imagen llena de ruido digital granulado.

Esto sucede cuando el sensor de imagen no capta suficiente luz.

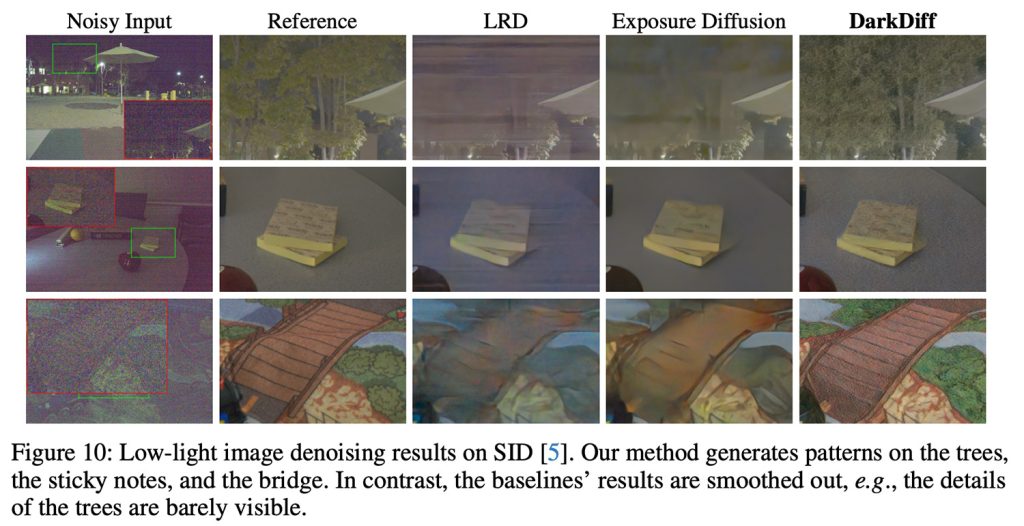

Para intentar que esto suceda, empresas como Apple están aplicando algoritmos de procesamiento de imágenes que han sido criticados por crear un efecto demasiado suave, similar al de una pintura al óleo, donde los detalles finos desaparecen o se reconstruyen en algo apenas reconocible o legible.

Entra en darkdef

Para combatir este problema, Apple e investigadores de la Universidad Purdue han desarrollado un modelo llamado DarkDiff. Así lo presentan en un estudio llamado DarkDiff: avances en la mejora sin procesar en condiciones de poca luz mediante la reelaboración de modelos de difusión para ISP de cámaras:

La fotografía de alta calidad en condiciones de iluminación extremadamente baja es un desafío pero efectiva para las cámaras digitales. Con hardware informático avanzado, los algoritmos tradicionales del procesador de señal de imagen (ISP) de la cámara están siendo reemplazados gradualmente por redes profundas eficientes que mejoran de manera más inteligente las imágenes sin procesar ruidosas. Sin embargo, los modelos existentes basados en regresión a menudo subestiman los errores de píxeles y dan como resultado un suavizado excesivo de fotografías con poca luz o sombras profundas. Trabajos recientes han intentado abordar esta limitación entrenando un modelo extendido desde cero, pero esos modelos aún tienen dificultades para recuperar detalles de imagen nítidos y colores precisos. Presentamos un marco novedoso para mejorar imágenes sin procesar con poca luz mediante la reelaboración de modelos de difusión generativa previamente entrenados con cámara ISP. Amplios experimentos muestran que nuestro método ofrece lo último en términos de calidad de percepción en tres desafiantes puntos de referencia de imágenes sin procesar con poca luz.

En otras palabras, en lugar de aplicar IA en la etapa de posprocesamiento, reelaboraron Stable Diffusion (un modelo de código abierto entrenado en millones de imágenes) para comprender qué detalles debería Teniendo en cuenta que su contexto general existe en las áreas oscuras de las fotografías y lo integra en el proceso de procesamiento de señales de imágenes.

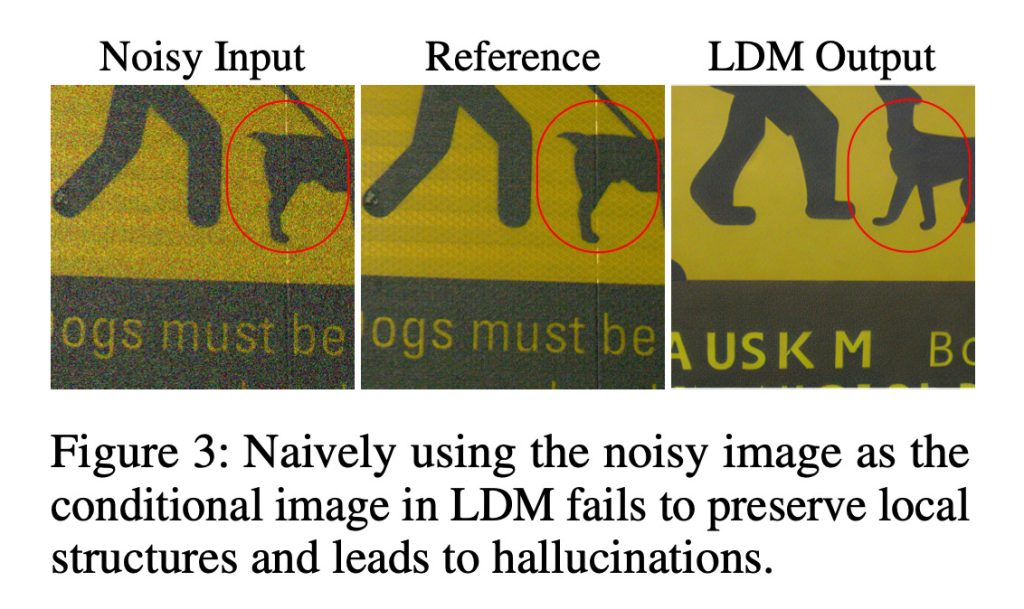

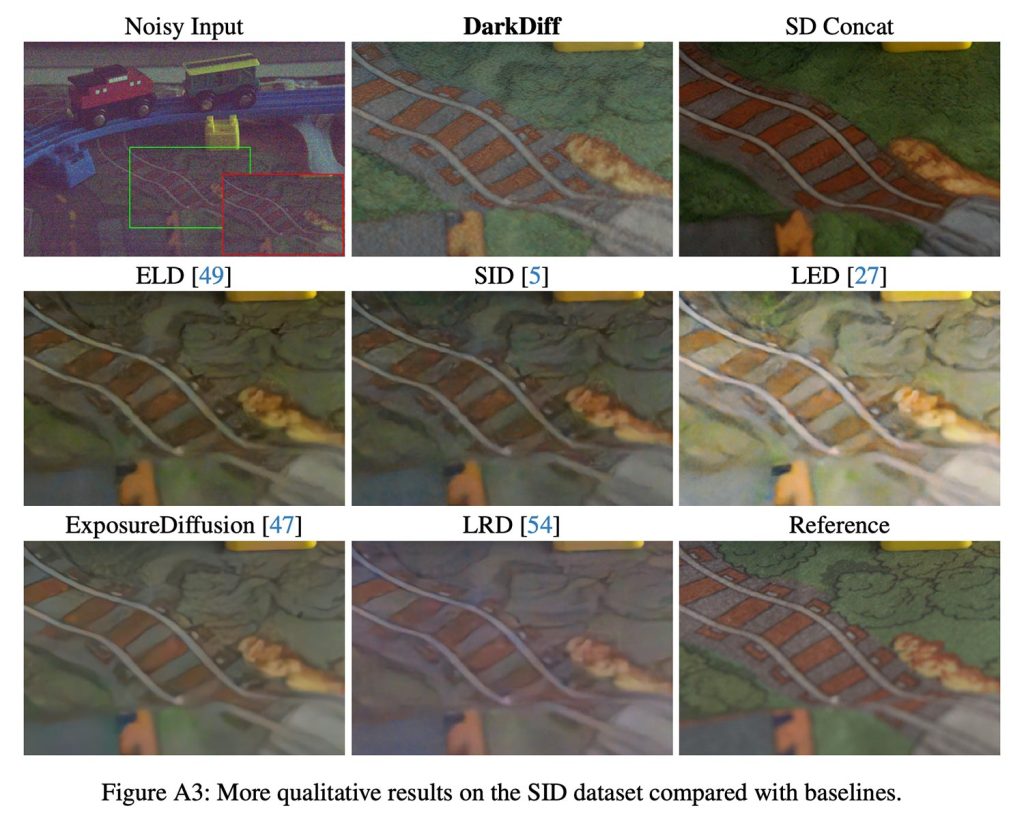

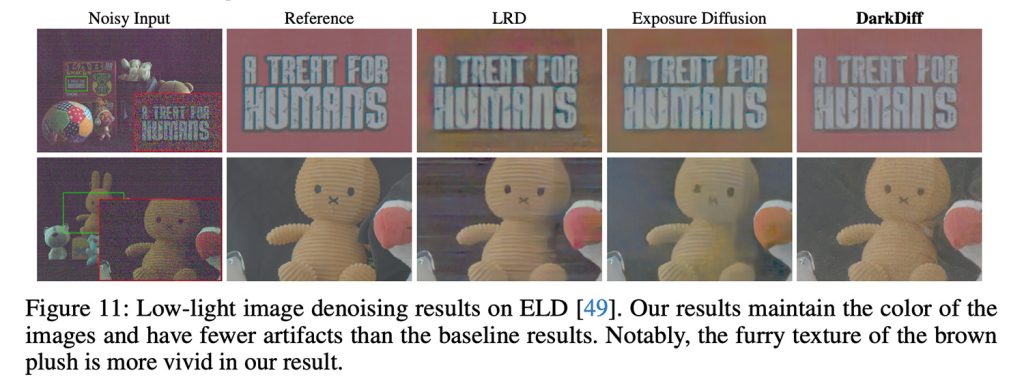

De hecho, su enfoque introduce un método que calcula la atención en parches de imágenes locales, lo que ayuda a preservar la estructura local y alivia alucinaciones como la imagen a continuación, donde la IA de reconstrucción cambia completamente el contenido de la imagen.

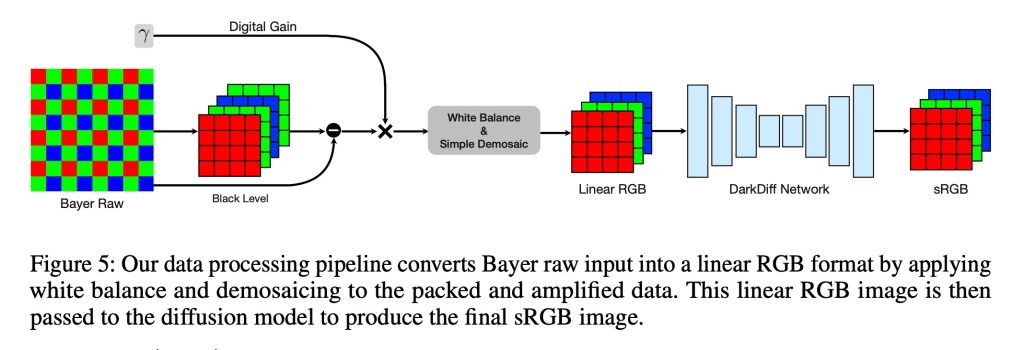

Con este enfoque, el ISP de la cámara aún maneja el procesamiento inicial necesario para comprender los datos sin procesar del sensor, incluidos pasos como el balance de blancos y la demostración. DarkDiff luego opera sobre esta imagen RGB lineal, desnaturalizándola y creando directamente la imagen sRGB final.

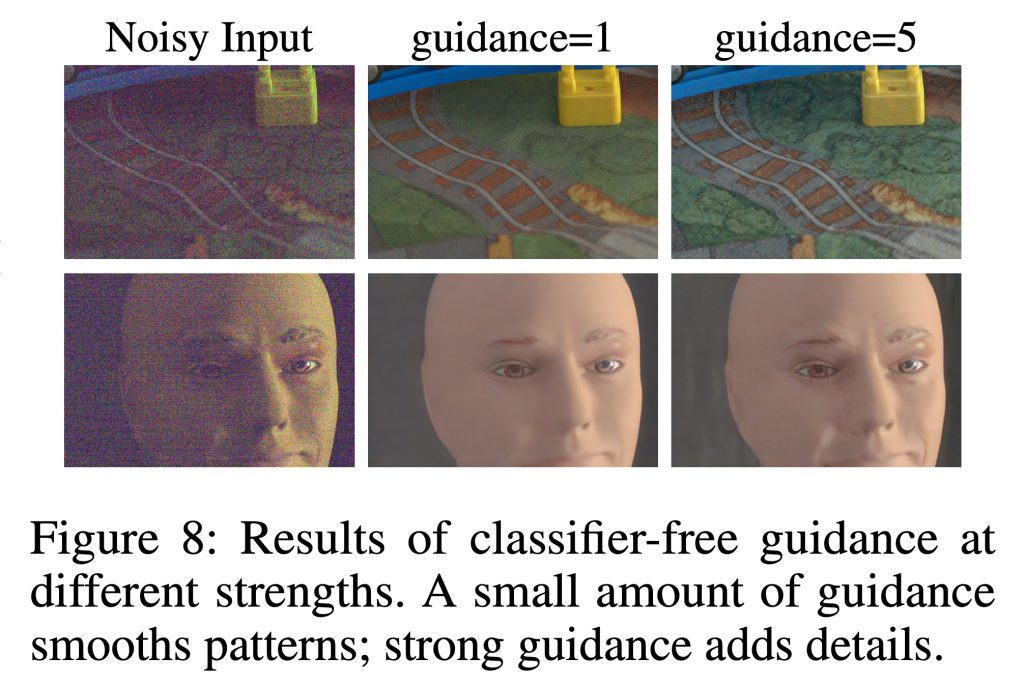

DarkDiff también utiliza una técnica de difusión estándar llamada guía sin clasificador, que esencialmente controla con qué fuerza el modelo debe seguir la imagen de entrada, en comparación con sus antecedentes visuales aprendidos.

Con una guía baja, el modelo produce patrones suaves, mientras que una guía creciente lo alienta a producir texturas nítidas y detalles finos (lo que, a su vez, aumenta el riesgo de crear artefactos no deseados o contenido alucinado).

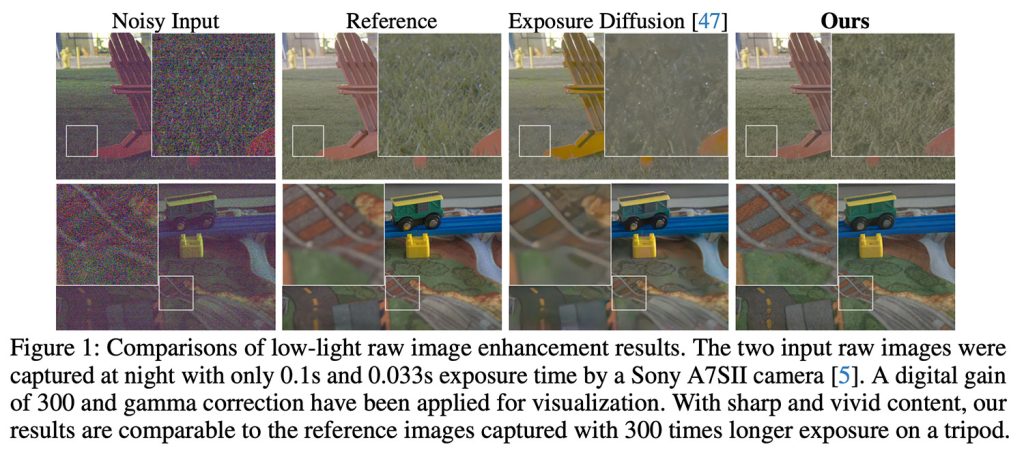

Para probar DarkDiff, los investigadores utilizaron fotografías reales tomadas con luz extremadamente baja con cámaras como la Sony A7SII, comparando los resultados con otros modelos de mejora sin procesar, incluida la exposición-difusión y una línea de base basada en difusión.

Las imágenes de prueba se capturaron de noche con tiempos de exposición de tan solo 0,033 segundos y se compararon versiones mejoradas de DarkDef con fotografías de referencia capturadas en un trípode con exposiciones 300 veces más largas.

A continuación se muestran algunos resultados (que le animamos a ver) en plena calidad En el estudio original):

Darkdef no está exento de problemas

Los investigadores señalan que su procesamiento basado en IA es significativamente más lento que los métodos tradicionales y probablemente requeriría procesamiento en la nube para altos requisitos computacionales que agotarían rápidamente las baterías si se ejecutaran localmente en los teléfonos. Además, también señalan las limitaciones del reconocimiento de texto que no está en inglés en escenas con poca luz.

También es importante tener en cuenta que en ninguna parte de la investigación se sugiere que DarkDefinition llegue pronto a los iPhone. Aún así, el trabajo demuestra el enfoque continuo de Apple en los avances en la fotografía computacional.

En los últimos años, esta se ha convertido en un área de interés cada vez más importante en todo el mercado de teléfonos inteligentes, ya que los consumidores exigen más capacidades de cámara de las que las empresas pueden colocar físicamente en sus dispositivos.

Para leer el estudio completo y ver comparaciones adicionales entre DarkDiff y otros métodos de eliminación de ruido, Sigue este enlace.