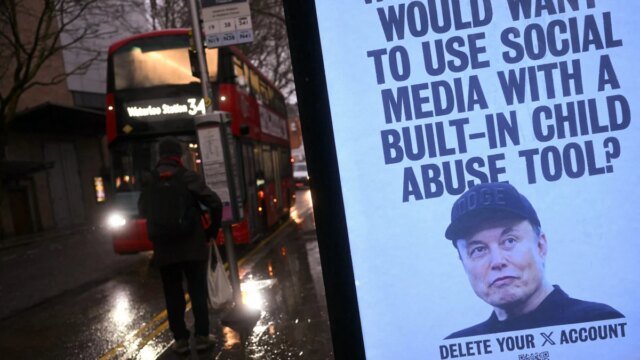

La verdadera escala del problema de los deepfake de Grok se está volviendo más clara a medida que la plataforma de redes sociales y su startup de inteligencia artificial xAI chatbot enfrentan una investigación en curso por parte de organismos de control de seguridad.

Según un Informe Por el Centro para la Lucha contra el Odio Digital (CCDH) y un colectivo investigación por Los New York TimesGrok aún pudo generar aproximadamente 3 millones de imágenes sexuales, incluidas 23.000 que parecían representar a niños durante un período de 10 días después de la supuesta represión de xAI contra los deepfakes.vendaje” CCDH examinó una muestra de respuestas de la herramienta de edición con un solo clic de Grok, que todavía está disponible para X usuarios, y calculó que más de la mitad de las respuestas del chatbot incluían contenido sexual.

Groke Ban: los países están considerando bloquear los chatbots de IA para contenido sexual objetable

D Los New York Times El informe encontró que aproximadamente 1,8 millones de los 4,4 millones de imágenes de Grok eran de naturaleza sexual, algunas de las cuales representaban a personas influyentes y celebridades conocidas. La publicación atribuyó el fuerte aumento en el uso de Grok a la publicación pública del CEO Elon Musk, donde se muestra a sí mismo en bikini, realizada por Grok.

“Esto es violencia a escala industrial contra mujeres y niñas”, dijo a la publicación el director ejecutivo del CCDH, Imran Ahmed. “Existen herramientas para empujar, pero no tienen la distribución, facilidad de uso o integración en una gran plataforma que Elon Musk tenía con Grok”.

Grok ha sido criticado por crear material de abuso sexual infantil (CSAM), tras informes de que el chatbot X produjo imágenes de menores con poca ropa. La plataforma reconoció el problema y dijo que estaba solucionando urgentemente “fallos de seguridad”.

Velocidad de la luz triturable

La empresa matriz de Grok, xAI, está siendo investigada por varios gobiernos extranjeros y por el estado de California por su papel en la creación de sexo. “Sin ropa” es deepfake Personas y menores. Algunos países incluso han prohibido temporalmente la plataforma mientras continúan las investigaciones.

En respuesta, xAI dijo que estaba impidiendo que Grok editara fotos cargadas por los usuarios para mostrar ropa reveladora, los problemas originales señalados por los usuarios a principios de este mes. Pero según informes recientes guardián Los usuarios de la aplicación Grok aún pueden crear fotografías editadas con IA de mujeres reales en bikini y luego subirlas al sitio.

Este tweet no está disponible actualmente. Se está cargando o eliminando.

En un informe de agosto, el editor de Mashable, Timothy Beckworth, notó problemas con los guardias de seguridad de Grok, incluido el hecho de que Grok Imagine crea fácilmente imágenes y videos sexualmente sugerentes de personas reales. Grok Imagine incluye configuraciones de moderación y protecciones destinadas a bloquear ciertos mensajes y respuestas, pero Musk también ha anunciado a Grok como un simple chatbot convencional que incluye una configuración “picante” para contenido sexual. OpenAI también se burló de una configuración NSFW, alegando en la demanda que su producto ChatGPT no es seguro para los usuarios.

Los organismos de control de la seguridad en línea han advertido al público durante mucho tiempo sobre el papel de la IA generativa en el aumento del número de CSAM generados artificialmente, así como de imágenes íntimas no consensuales (NCII) abordadas en la Ley Take It Down de 2025. Según la nueva ley estadounidense, los editores en línea deben cumplir con las solicitudes para eliminar los deepfakes que no cumplan con las normas o enfrentar sanciones.

Un informe de 2024 de Fundación Internet Watch (IWF) Descubrió que las herramientas de inteligencia artificial generativa estaban directamente relacionadas con el creciente número de CSAM en la web oscura, que representaba principalmente a niñas en escenas sexuales o alteraba digitalmente pornografía real para incluir escenas infantiles. Las herramientas de inteligencia artificial y las aplicaciones “nudify” se han relacionado con el crecimiento Acoso cibernético Y Acoso sexual mediante IA.