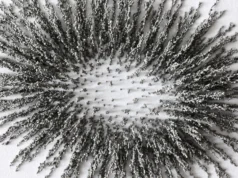

Los investigadores han desarrollado una técnica que permite a los programas de inteligencia artificial (IA) mapear mejor espacios tridimensionales utilizando imágenes bidimensionales tomadas por múltiples cámaras. Debido a que esta técnica funciona de manera eficiente con recursos computacionales limitados, es prometedora para mejorar la navegación de vehículos autónomos.

“La mayoría de los vehículos autónomos utilizan potentes programas de inteligencia artificial llamados transformadores de visión para tomar imágenes 2D de múltiples cámaras y representar el espacio 3D alrededor del vehículo”, dice el autor correspondiente de un artículo sobre trabajo y electricidad, Tianfu Wu, profesor asociado de en ingeniería informática en la Universidad Estatal de Carolina del Norte. “Sin embargo, aunque cada uno de estos programas de IA adopta un enfoque diferente, todavía hay mucho margen de mejora.

“Nuestra técnica, llamada Multi-View Attentive Context (MvACon), es un complemento plug-and-play que se puede combinar con estos Vision Transformer AI existentes para mejorar la capacidad de mapear espacios 3D”, dice Wu. ” “Los transformadores de visión no obtienen datos adicionales de sus cámaras, simplemente pueden hacer un mejor uso de los datos”.

MvACon funciona eficazmente modificando un enfoque llamado atención de parche a clúster (PaCa), que Wu y sus colegas lanzaron el año pasado. PaCa Transformer permite a las IA identificar objetos en una imagen de manera más eficiente y efectiva.

“El desarrollo clave aquí es aplicar lo que hemos hecho con PaCa al desafío de mapear el espacio 3D usando múltiples cámaras”, dice Wu.

Para probar el rendimiento de MvACon, los investigadores lo utilizaron junto con tres transformadores de visión líderes: BEVFormer, variante BEVFormer DFA3D y PETR. En cada caso, los transformadores de visión recogieron imágenes 2D de seis cámaras diferentes. En los tres casos, MvACon mejoró significativamente el rendimiento de cada transformador de visión.

“El rendimiento mejoró especialmente cuando se trataba de encontrar objetos, así como la velocidad y orientación de esos objetos”, dice Wu. “Y el aumento en la demanda computacional para agregar MvACon a los transformadores de visión fue casi insignificante.

“Nuestros próximos pasos incluyen probar MvACon con conjuntos de datos de referencia adicionales, así como probarlo con entradas de video reales de vehículos autónomos. Si MvACon continúa superando a los transformadores de visión existentes, somos optimistas de que se adoptará para un uso generalizado”.

“Contexto atento a múltiples vistas para la detección de objetos 3D de múltiples vistas”, que se presentará en la Conferencia IEEE/CVF sobre visión por computadora y reconocimiento de patrones, el 20 de junio en Seattle, Washington. El primer autor del artículo es Xianpeng. Liu, un reciente Ph.D. Graduados del estado de Carolina del Norte. El artículo fue escrito en coautoría por C Zheng y Chen Chen de la Universidad de Florida Central. Ming Qian y Nan Xue de Ant Group; y Zibin Zhang y Chen Li del Centro de Investigación OPPO de EE. UU.

Este trabajo fue apoyado por la Fundación Nacional de Ciencias, bajo las subvenciones 1909644, 2024688 y 2013451. Oficina de Investigación del Ejército de EE. UU., bajo las subvenciones W911NF1810295 y W911NF2210010; y un fondo de donaciones para investigación de Innopeak Technology, Inc.