La atención de salud mental puede ser difícil acceder a la cobertura de seguro de los Estados Unidos y no hay tantos profesionales de salud mental para satisfacer las necesidades de la nación, lo que lleva a una larga espera y una costosa atención.

Ingrese la inteligencia artificial.

Las aplicaciones de salud mental de IA, desde el rastreador de humor hasta los botes de chat que imitan los terapeutas humanos, se están propagando en el mercado. Aunque pueden ofrecer una forma barata y accesible de satisfacer la diferencia en nuestro sistema, existen más preocupaciones morales en la IA para la atención de salud mental, especialmente para los niños.

La mayoría de las aplicaciones de salud mental de IA están diseñadas para irregulares y adultos, pero hay una conversación creciente con los niños sobre su uso. Briana Moore, PhD, profesora asistente de humanidades y biouts de salud en el Centro Médico de la Universidad de Rochester (URMC), quiere asegurarse de que la conversación involucre reservas morales.

“Nadie está hablando de lo que es diferente en los niños: cómo funcionan sus mentes, cómo están integrados en su unidad familiar, cómo su decisión es diferente”. Revista de pediatría. “Los niños son particularmente débiles. Su desarrollo social, emocional y académico está en una etapa diferente a los adultos”.

De hecho, los botes de chat de salud mental de IA pueden dañar el desarrollo social de los niños. La evidencia sugiere que los niños creen que el robot tiene una “posición moral y vida mental”, lo que plantea preocupaciones de que los niños, especialmente los jóvenes, pueden asociarse con los botes de chat a expensas de construir relaciones saludables con las personas.

El contexto social de un niño: su familia y sus colegas son esenciales para su salud mental. Es por eso que los terapeutas pediátricos no tratan a los niños de forma aislada. Observan la familia y las relaciones sociales del niño para garantizar la seguridad del niño e incluir miembros de la familia en el tratamiento. Los botes de chat de IA no tienen acceso a información sobre este importante contexto y pueden perder oportunidades de intervención cuando un niño está en riesgo.

AI Chat Boats, y en general el sistema de IA, también estropean las desigualdades actuales de salud.

“La IA es tan buena como entrenada en los datos”, dijo Jonathan Herrington, profesor asistente de comentarios, profesor asistente de filosofía y bilados. “Desafortunadamente, sin esfuerzos realmente cautelosos para construir datos representativos, estos barcos de chat de IA no podrán servir a todos”.

El género, la raza, la raza de un niño, donde vive, y la riqueza relativa de su familia afecta los eventos negativos de su infancia, como abuso, negligencia, prisión u observación de violencia, abuso de material o sufrimiento de enfermedades mentales en el hogar o la sociedad. Los niños que experimentan estos eventos requieren un cuidado intensivo de la salud mental y tienen menos probabilidades de poder acceder.

“Los niños con bajos recursos no pueden permitirse la terapia humana con humanos y, por lo tanto, confían en la terapia humana en lugar de la terapia humana en estos botes de chat de IA”, dijo Herrington. “Los botes de chat de IA pueden convertirse en herramientas valiosas, pero nunca deben reemplazar la terapia humana”.

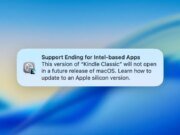

La mayoría de los barcos de chat de terapia de IA no son actualmente regulares. La Administración Americana de Alimentos y Medicamentos ha aprobado solo una aplicación de salud mental basada en AI para el tratamiento de la depresión mayor en adultos. Sin las reglas, no hay forma de proteger el mal uso, la falta de informes o los datos de capacitación o el uso del acceso al consumidor.

“Hay muchas preguntas abiertas que no han sido respondidas ni claramente declaradas”, dijo Moore. “No estamos abogando por que esta tecnología se vea obstaculizada. No estamos diciendo que la IA o los barcos de terapia se deshagan. Estamos diciendo cómo debemos pensar en usarlos, especialmente cuando se trata de poblaciones como niños y su atención de salud mental”.

Moore y Herrington contribuyeron al comentario con el profesor asociado, Serfe Technic, PhD, en el centro de Biouthex y Humanities at Sun Optt Medical. Los técnicos estudian la biomética de la psicología y el uso de la IA en la filosofía de la psicología y la ciencia académica.

En el futuro, el equipo espera contribuir con los desarrolladores para comprender mejor cómo desarrollan barcos de chat de terapia basados en AI. En particular, quieren saber si los desarrolladores incorporan preocupaciones morales o de seguridad en el proceso de desarrollo, y su modelo de IA está informado por la investigación y el compromiso con niños, adolescentes, padres, niños o hijos o médicos.